Kafka是大型架构的必备技能,下面我重点详解 Kafka 消费者如何实现高吞吐量@mikechen

Kafka消费者高吞吐

Kafka 作为数据管道的核心组件,其消费者的吞吐量直接决定了下游数据处理应用的实时性和处理能力。

如果消费者吞吐量不足,会导致数据积压(Consumer Lag),影响下游应用的及时性,甚至造成系统瓶颈。

在高并发、数据量大的场景下,只有具备足够吞吐量的消费者才能及时处理涌入的数据,保证系统的稳定性和响应速度。

Kafka消费者高吞吐关键技术

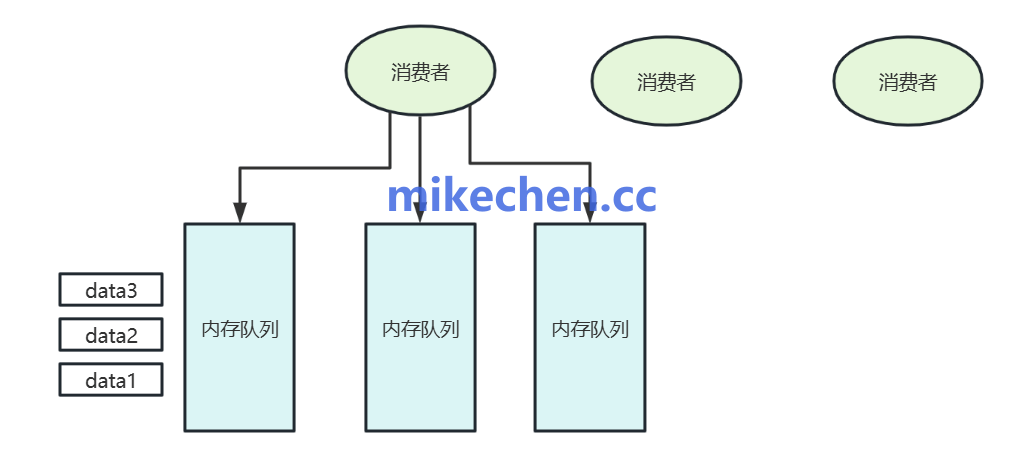

多线程消费模型

在单个消费者实例中,使用多个线程并行地处理从 Kafka 拉取到的消息。

ConsumerRecords<K, V> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<K, V> record : records) {

executor.submit(() -> processRecord(record)); // 并发处理

}

能够并发处理多条消息,显著提升单个消费者的吞吐量,尤其是在业务逻辑处理耗时的情况下。

更好地利用 CPU 资源: 充分利用多核 CPU 的并行处理能力。

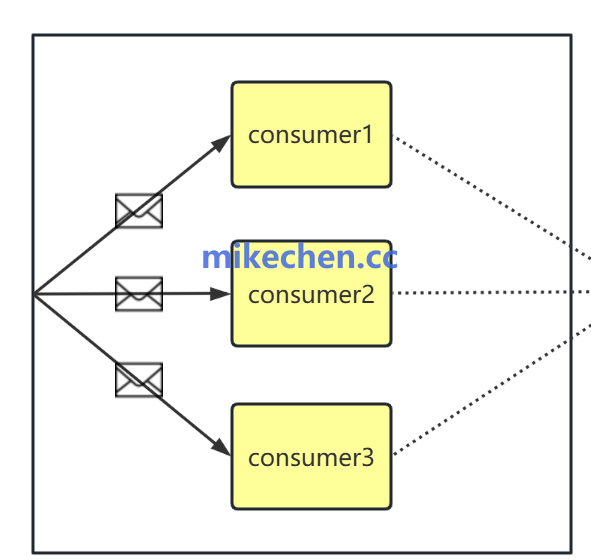

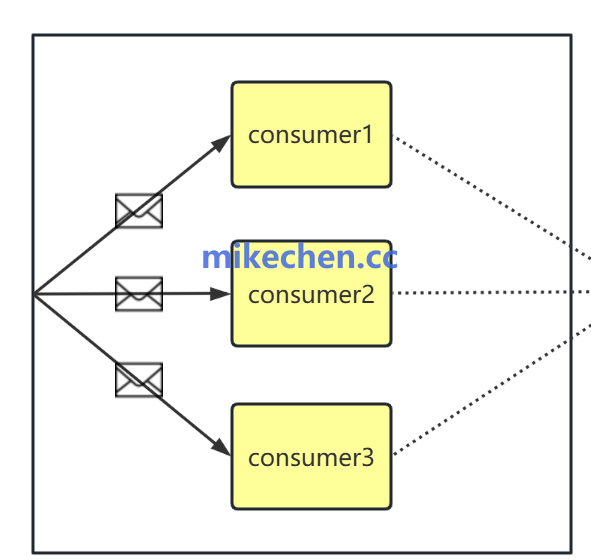

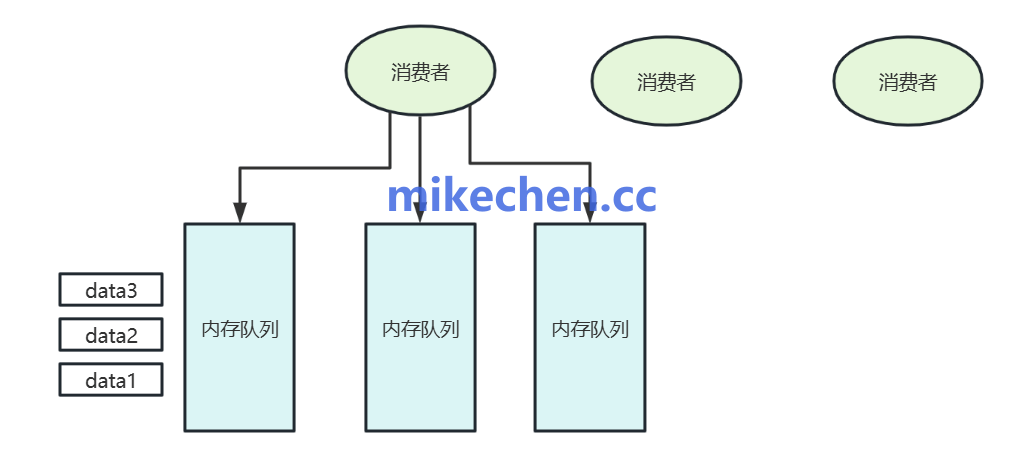

多消费者分组

为了进一步提升并发和吞吐,Kafka 支持将多个消费者实例组成一个Consumer Group。

public class KafkaConsumerGroupDemo {

public static void main(String[] args) {

int consumerCount = 3; // 启动3个消费者实例

String topic = "test-topic";

String groupId = "my-consumer-group";

for (int i = 0; i < consumerCount; i++) {

Thread thread = new Thread(new ConsumerWorker(topic, groupId), "consumer-" + i);

thread.start();

}

}

}

当单个消费者的处理能力达到瓶颈时,可以通过增加同一个消费者组内的消费者实例来线性扩展消费能力。

多个消费者实例同时消费不同的分区,可以显著提高整个消费者组对该主题的消费吞吐量。

客户端参数调优

Kafka 客户端提供了丰富的配置参数,合理调整这些参数可以显著影响消费者的吞吐量。

fetch.max.bytes = 52428800 # 50MB fetch.min.bytes = 1048576 # 1MB fetch.max.wait.ms = 200 max.partition.fetch.bytes = 5242880

| 参数 | 含义 | 建议配置 |

|---|---|---|

fetch.max.bytes |

每次 poll 能拉的最大字节数 | 如 50MB,提高批量拉取能力 |

fetch.min.bytes |

至少拉多少字节才返回 | 如 1MB,提高批次处理效率 |

fetch.max.wait.ms |

如果数据不足 min.bytes,等待多久返回 |

如 100~500ms,拉满再返回 |

max.partition.fetch.bytes |

每个分区最多拉多少数据 | 1MB~5MB,防止个别分区占用过多 |

调整处理的批量大小

Kafka 支持批量拉取 + 批量处理,是实现高吞吐最直接的方式。

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

List<String> batch = new ArrayList<>();

for (ConsumerRecord<String, String> record : records) {

batch.add(record.value());

}

processBatch(batch); // 批量处理

通过以上策略,Kafka消费者可以在保证数据可靠性的前提下,实现高效、稳定的高吞吐消费能力。