负载均衡是大型架构的必备技能,下面我重点来详解负载均衡模式@mikechen

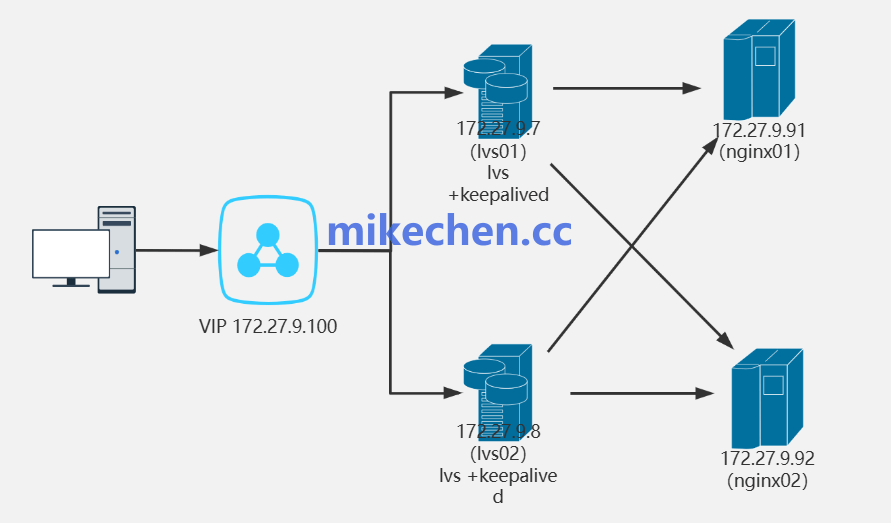

负载均衡(单层架构)

在单层负载均衡架构中,负载均衡器直接位于客户端和一组后端服务器之间。

所有来自客户端的请求首先到达负载均衡器,然后由它根据预设的算法(如轮询、最少连接、哈希等)将请求转发给后端服务器池中的某一台服务器。

比如:如 Nginx、LVS、HAProxy。。。等等,将请求按照一定算法分发到后端服务器集群。

如下图所示:

架构简单:易于部署和管理,适用于中小型应用或流量相对可预测的场景。

但是,也有一个致命的缺点,单点故障。

如果负载均衡器本身出现故障,整个系统将不可用。

并且,当流量非常大时,单个负载均衡器可能会成为瓶颈,影响系统的整体性能。

负载均衡(双层架构)

为了解决单层架构的单点故障和性能瓶颈问题,双层负载均衡架构应运而生。

这种架构通常在前端引入全局负载均衡(GSLB),将用户请求引导至不同的数据中心或区域。

如下图所示:

第一层负载均衡器面对外部请求,将流量分发到第二层负载均衡器。

第二层负载均衡器负责将流量进一步分发到具体的应用服务器或服务节点。

优点:

消除单点故障的风险,提高系统的冗余和可用性。

可以通过第二层负载均衡器实现对不同业务模块的流量隔离和细粒度控制。

缺点:

架构复杂度增加,维护成本提高。

请求路径变长,可能引入一定的延迟。

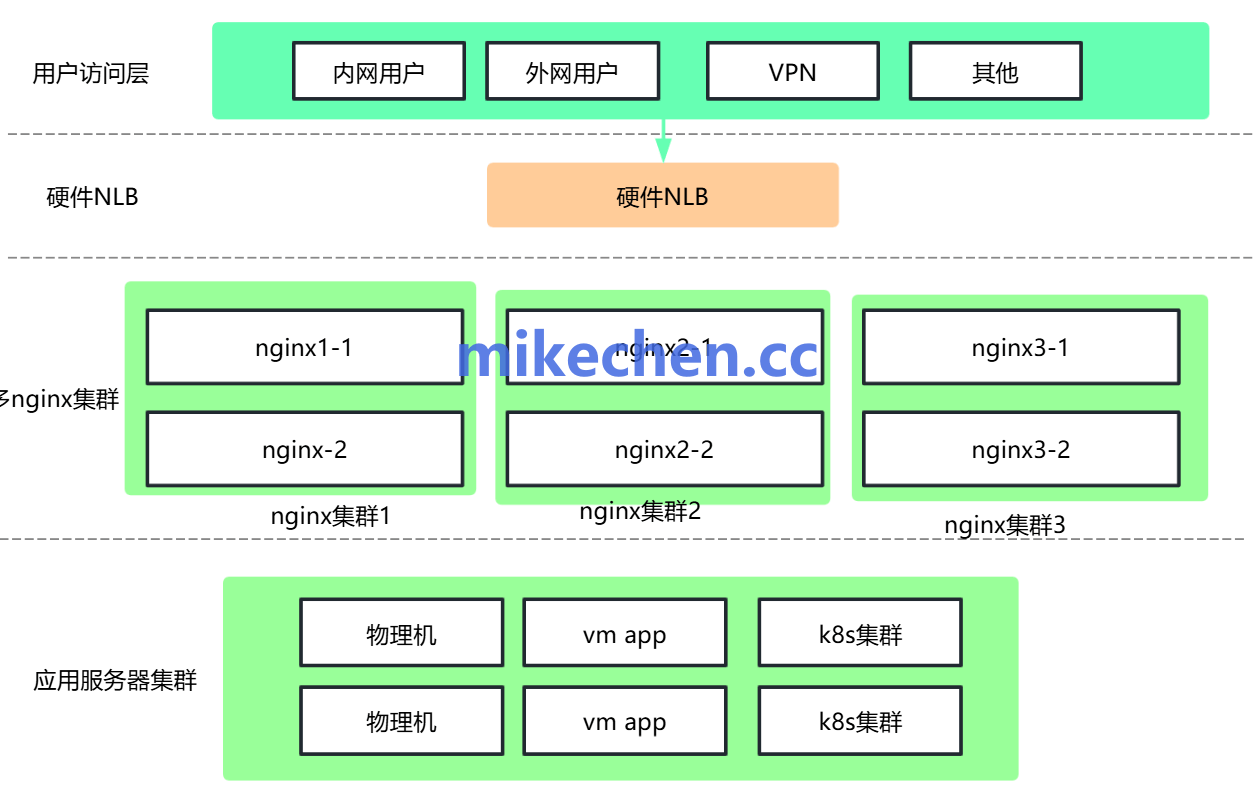

负载均衡(多层架构)

多层负载均衡架构是在双层基础上进一步细分,可以有三层、或多层负载均衡。

常见于大型复杂系统,如下图所示:

第一层(DNS负载均衡)

通过DNS将用户请求分配到不同的地理区域或数据中心,这是全局负载均衡的常见实现方式。

第二层(L4负载均衡)

在数据中心内部,第一道负载均衡器通常是基于传输层(TCP/UDP)的负载均衡器。

它快速地将请求分发到后端服务器或下一层负载均衡器。例如,LVS、HAProxy可以配置为L4模式。

第三层(L7负载均衡)

位于L4负载均衡器之后,负责处理应用层(HTTP/HTTPS)的请求。

它可以根据请求的内容(如URL路径、HTTP头部、Cookie等)将请求分发到特定的服务或服务器集群。

优点:

高度可扩展,支持海量流量和复杂业务逻辑。

提供更灵活的流量管理和容灾能力。

缺点:

系统架构复杂度显著提升,运维和监控难度加大。

设计和调优难度较大,需要多方面的专业能力。

Nginx负载均衡架构总结

单层负载均衡架构适合小规模、简单系统。

双层负载均衡架构适合中等规模,具备一定冗余和分层管理需求的系统。

多层负载均衡架构适合大型复杂系统,需要分布式流量管理和高可用性的场景。